Để thực hiện SEO tốt, thì thiết lập một file robots.txt chuẩn là việc bắt buộc. Đối với nhiều bạn, công việc này không mấy dễ dàng vì liên quan đến mảng lập trình. Trong lúc thực hiện sẽ xảy ra không ít lỗi hoặc sẽ có chỗ khó hiểu. Tại bài viết này, chúng tôi sẽ cung cấp cho các bạn những thông tin cần thiết để hiểu và vận dụng file này vào việc SEO tốt nhất có thể.

File robots.txt là một tệp chứa văn bản có định dạng kiểu .txt. Tệp này cho phép bạn hướng dẫn con bot của Google cách thu thập thông tin dữ liệu từ trang web của bạn. Nó nằm trong Robots Exclusion Protocol (REP- nghĩa là Giao thức loại trừ robot).

REP là một nhóm các tiêu chuẩn được Google chính thức công nhận dùng để điều hướng robot của google truy cập, index bài viết và các công việc khác.

Ngoài robots.txt, REP còn chứa Meta Robots, Site-Wide Instructions, Page-Subdirectory. Những thẻ này hỗ trợ điều chỉnh công việc của con bot và ngăn nội dung trùng lặp.

Các công cụ có 2 nhiệm vụ chính:

Để phân tích dữ liệu thì con bot sẽ quét qua khắp các trang web có liên quan đến trang của bạn. Nó cần thu thập dữ liệu từ số lượng cực lớn trang web khác nhau. Đường đi của nó tạo thành một mạng lưới nên quá trình này còn được gọi là “Spidering”.

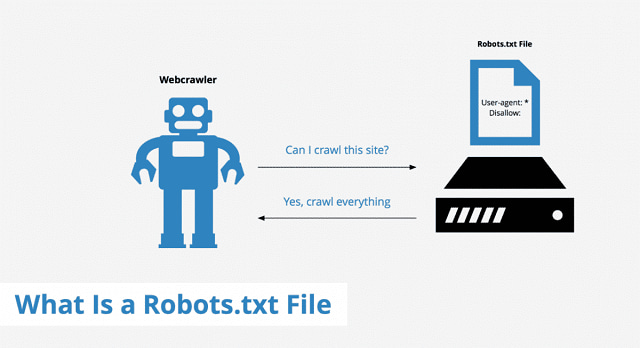

Điều đầu liên các bot làm khi tiếp cận một trang web là truy cập vào file robots.txt để được hướng dẫn. File này chứa thông tin cần thiết để điều hướng, quy định tệp được truy cập hoặc không được truy cập.

Trong trường hợp bạn không ghi lệnh (command) vào file robots.txt thì con bot sẽ đi crawl hết các thông tin trong web. Hoặc nếu bạn không tạo file này, kết quả cũng tương tự trên.

Dưới đây là 2 trường hợp bạn cần sử dụng file robots.txt

Khi đó, việc thu thập lượng lớn thông tin thừa như vậy sẽ khiến máy bạn tốn tài nguyên nhiều hơn. Vì vậy, hạn chế quyền truy cập sẽ làm tăng hiệu năng cho mỗi lần quét.

Nếu không có file robots.txt, mọi thông tin trong trang web đều được mặc định là công khai. Do đó, con bot sẽ quét qua hết các thông tin không cần tiết, từ đó giảm hiệu năng của việc phân tích. Như đã nói ở trên, việc quét các thông tin thừa thật sự tốn lượng lớn tài nguyên.

Nếu bạn không cài đặt file robots.txt chuẩn SEO, rất có thể con bot đã bỏ qua một số thông tin quan trọng. Ví dụ: khi bạn cài file không chuẩn, con bot chỉ truy cập vào thông tin thừa mà không vào các tiêu chí đánh giá SEO. Kết quả là nó không tìm thấy thông tin đánh giá, nên sẽ cho rằng web bạn không đạt và không cho index.

Một số định dạng cơ bản có trong file robots.txt

User-agent:

Disallow:

Allow:

Crawl-delay:

Sitemap:

Trong đó:

Do đó bạn cần cài nó vào GSC (Google Search Console)

Sau đây, chúng mình liệt kê 5 ví dụ cách sử dụng các dòng lệnh trên.

Để thông báo các bọ không được phân tích dữ liệu nào hết. Ta nhập dòng lệnh:

User-agent: *

Disallow: /

Để thông báo tất cả dữ liệu đều ở chế độ công khai, các bot có thể tùy ý truy cập. Ta nhập dòng lệnh:

User-agent: *

Disallow:

Để ngăn con bot Google thu thập và tìm thông tin trang chứa địa chỉ www.example.com/example-subfolder/. Ta nhập dòng lệnh:

User-agent: Googlebot

Disallow: /example-subfolder/

Để ngăn con bot Bing thu thập và tìm thông tin trang chứa địa chỉ www.example.com/example-subfolder/blocked-page. Ta nhập dòng lệnh:

User-agent: Bingbot

Disallow: /example-subfolder/blocked-page.html

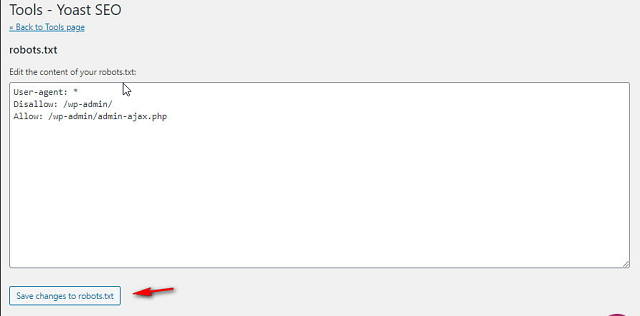

Sau đây là một file robots.txt đạt chuẩn trong WordPress:

User-agent: *

Disallow: /wp-admin/

Allow: /

Sitemap: https://www.example.com/sitemap_index.xml

Lưu ý: Tham khảo thêm bài viết SEO là gì? để hiểu thêm lĩnh vực bạn dang làm và vì sao lại cần tạo file robots.txt cho chuẩn SEO

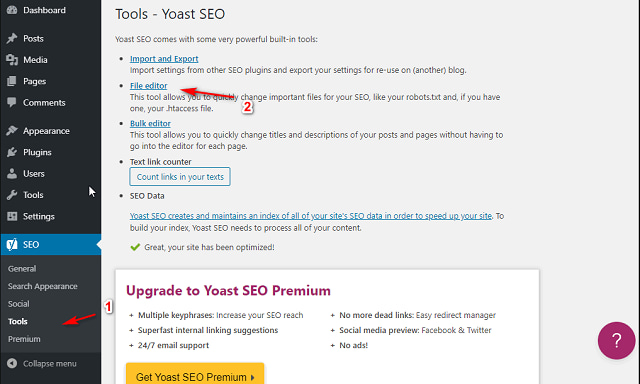

Bạn có thể dùng plugin Yoast SEO. Bạn truy cập vào SEO sau đó nhấp vào Tools.

Nhấp chuột chọn File Editor, xác nhận Lưu vào file robots.txt.

File robots.txt tiêu chuẩn cho blogspot

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://www.example.com/sitemap.xml {codeBox}

Lưu ý, bạn cần chỉnh sửa https://www.example.com thành web bạn cần thao tác.

Blogger không được truy cập vào root nên bạn cần dùng cách sau để điều chỉnh file robots.txt.

Bạn cần đăng nhập (login) tài khoản Blogger. Sau đó, chỉnh sửa trực tiếp tệp robots.txt.

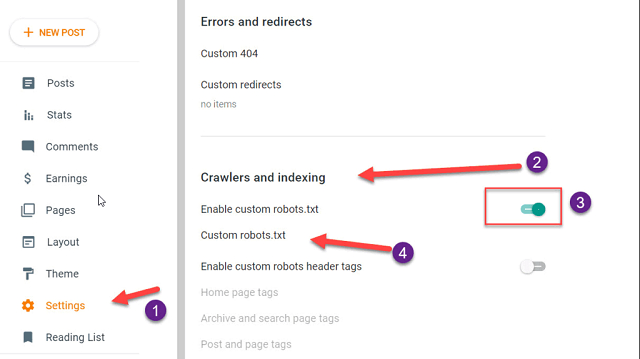

Bước 1: Đi tới Trang tổng quan Blogger và nhấp vào tùy chọn cài đặt (Settings).

Bước 2: Kéo trình Crawlers and indexing lên.

Bước 3: Bật nút cho phép chỉnh sửa robots.txt.

Bước 4: truy cập vào mục bên dưới (custom robots.txt) rồi kéo thả tệp của bạn vào là được.

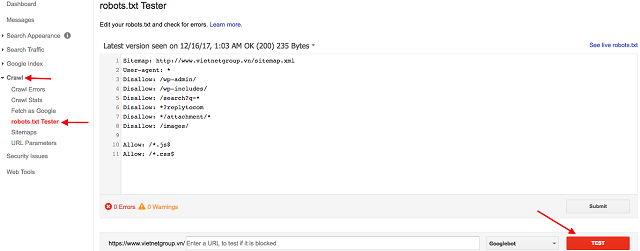

Có nhiều cách để kiểm tra nội dung của file robots.txt. Tuy vậy, để không sai sót, bạn nên dùng công cụ Tester của GSC.

Bước 1: Login vào GSC.

Bước 2: Click robots.txt Tester, trong mục Crawl.

Bước 3: Xác nhận kiểm tra, click vào TEST.

Tín hiệu xác nhận thành công là hiện chữ ALLOWS và nút TEST chuyển màu xanh. Trường hợp nếu lỗi, máy sẽ báo cụ thể cho bạn.

Lập trình cho file robots.txt là cần thiết với SEO nhưng không phải ai cũng có thể hoàn thành trơn tru được. Trong khi làm, sẽ mắc phải một số lỗi hoặc thắc mắc gì đó. Mình liệt kê 3 vấn đề thường xuyên gặp phải:

Vị trí của file robots.txt thông thường sẽ nằm ngay trong phần public_html đối với các add domain và tên miền phụ sẽ ở nay trong folder chứa code của website.

Đây không hẳn là một lỗi nó sẽ xuất hiện khi url đang kiểm tra đang bị chặn trong file trong robots.txt.

Lỗi này đôi khi sẽ xuất hiện khi bạn cố gắng submit một sitemap của web với công cụ tìm kiếm. Hãy loại bỏ url đang bị chặn trong file robots.txt để khắc phục lỗi này.

Với những thông tin trên, bạn đã biết thế nào là robots.txt. File này sẽ giúp cho trang web của bạn được bot Google quét thông tin một cách chính xác và tối ưu hơn. Với những thông tin đó, việc SEO web sẽ trở nên hiệu quả hơn. Mong những thông tin trên sẽ giúp đỡ ít nhiều để các bạn tăng hiệu suất việc SEO cho trang web của mình. Nếu bạn muốn tìm thêm những thông tin khác về SEO web, hãy theo dõi City IT để có những kiến thức bổ ích nhé.